Ein Recht auf Warnung

-

Das Dauerthema KI, in Südtirol wie auch rund um den Globus, ist sie eine allgegenwärtige Präsenz. In diesem Zusammenhang fällt oft das Stichwort der Risiken. Die Erschaffung einer gefälschten Realität etwa oder das generelle Gefahrenpotential von Fake News und Falschinformationen. Manch einer malt auch die Auslöschung aller Menschen als mögliche Zukunft an die Wand. Nun machen Mitarbeiter von KI-Unternehmen selbst auf die Thematik aufmerksam.

Es ist der vierte Juni. Ein offener Brief, verfasst in englischer Sprache, geht online, mit einem Titel, der beinah wie der Titel einer Diplomarbeit klingt: „Ein Recht auf Warnung vor fortgeschrittener künstlicher Intelligenz.“ Geschrieben und unterzeichnet von aktuellen und ehemaligen Mitarbeitern - manche mit ihrem vollen Namen, manche signieren anonym - des Softwareunternehmens OpenAI und des Google-Tochterunternehmens Google DeepMind – beide spezialisiert auf Erforschung und Entwicklung künstlicher Intelligenz.

-

Der Brief

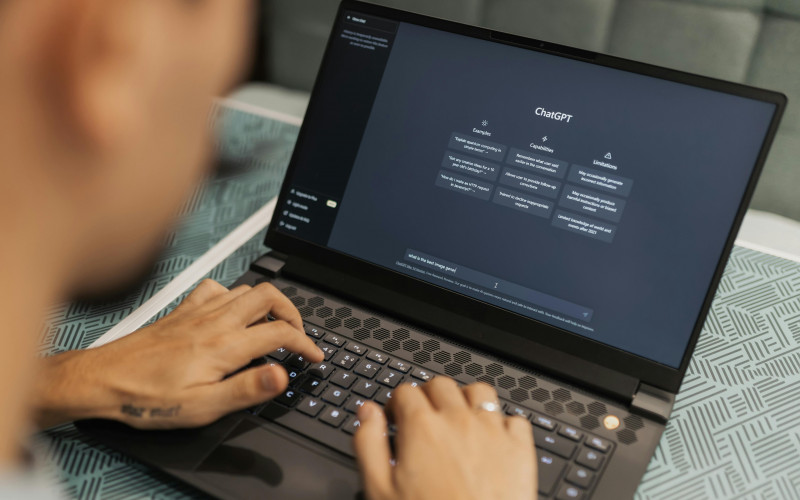

„Wir glauben an das Potenzial der KI-Technologie, der Menschheit einen beispiellosen Nutzen zu bringen“, so beginnt der Brief. Doch wo viel Licht, da viel Schatten. Auf der anderen Seite berge die künstliche Intelligenz in dieser Form noch nie dagewesene Risiken für die (Zukunft der) Menschheit. Zum einen könne sie zu einer weiteren Verschärfung von Ungleichheiten führen sowie ungeahnte Möglichkeiten der Missinformation, Manipulation und Desinformation eröffnen. Ferner gäbe es noch das absolute Horrorszenario einer autonom denkenden Maschine, die sich nicht mehr von ihren „Schöpfern“ kontrollieren lässt. Diese Entwicklung könne demnach bis zur Auslöschung der Menschheit führen.

„Der übliche Schutz von Whistleblowern ist unzureichend, weil er sich auf illegale Aktivitäten konzentriert, während viele der Risiken, über die wir uns Sorgen machen, noch nicht geregelt sind.“

„Es ist denkbar (wenn auch ungewiss), dass künftige KI-Systeme in der Lage sein werden, offensive Cyber-Operationen durchzuführen, Menschen im Dialog geschickt zu täuschen, Menschen zu schädlichen Handlungen zu manipulieren, Waffen zu entwerfen oder zu erwerben.“ steht etwa in einem Blog zu Sicherheit und Verantwortung auf der Website von Google DeepMind als mögliche Risiken einer hochentwickelten künstlichen Intelligenz.

„Wir glauben an das Potenzial der KI-Technologie, der Menschheit einen beispiellosen Nutzen zu bringen.“

Diese Risiken könne man behandeln mit der Leitung und Zusammenarbeit der wissenschaftlichen Fachwelt, der Öffentlichkeit und der politischen Entscheidungsträger. Doch genau dort liege der Hund begraben. Für KI-Unternehmen gäbe es große, finanzielle Reize sich derartigen Kontrollen und Aufsichten zu entziehen. Auch angepasste Strukturen der Unternehmensführung seien da nicht mehr ausreichend, um das grundlegend zu ändern.

KI-Unternehmen besäßen über wesentliche Informationen über die Fähigkeiten und Einschränkungen ihrer „Kinder“ sowie über das Gefahrenlevel, die verschiedene Risiken und Sicherheitsmaßnahmen, würden diese aber nicht mit der Öffentlichkeit teilen, da sie nur geringe Verpflichtungen gegenüber den Regierungen hätten und gar keine gegenüber den Zivilgesellschaften. Man brauche sich nicht erwarten, dass die Unternehmen solche Informationen freiwillig weitergeben würden. Implementiere man keine Aufsicht, die von Staaten ausgeht, so hätten nur Mitarbeiter die Gelegenheit die KI-Unternehmen zur Rechenschaft zu ziehen. Aber die Mitarbeiter würden weitreichenden Vertraulichkeitsverbindungen unterliegen, die sie hindern würden ihre Bedenken frei zu äußern. „Der übliche Schutz von Whistleblowern ist unzureichend, weil er sich auf illegale Aktivitäten konzentriert, während viele der Risiken, über die wir uns Sorgen machen, noch nicht geregelt sind.“ Die Mitarbeiter würden sich vor Vergeltungsmaßnahmen fürchten, solche Vorfälle hätte es in der Vergangenheit innerhalb der ganzen Branche gegeben.

-

Um dem entgegenzutreten fordern sie KI-Unternehmen auf, sich an vier Prinzipien festzuhalten, die da lauten:

1. Das Unternehmen wird keine Vereinbarung abschließen oder durchsetzen, die eine „Verunglimpfung“ oder Kritik am Unternehmen wegen risikobezogener Bedenken verbietet, und es wird auch keine Vergeltungsmaßnahmen für risikobezogene Kritik ergreifen, indem es einen wirtschaftlichen Vorteil verhindert.

2. Das Unternehmen ermöglicht einen überprüfbar anonymen Prozess für aktuelle und ehemalige Mitarbeiter, um risikobezogene Bedenken gegenüber dem Vorstand des Unternehmens, den Aufsichtsbehörden und einer geeigneten unabhängigen Organisation mit einschlägigem Fachwissen vorzubringen.

3. Das Unternehmen fördert eine Kultur der offenen Kritik und ermöglicht seinen derzeitigen und ehemaligen Mitarbeitern, risikobezogene Bedenken bezüglich seiner Technologien gegenüber der Öffentlichkeit, dem Vorstand, den Aufsichtsbehörden oder einer geeigneten unabhängigen Organisation mit einschlägigem Fachwissen vorzubringen, solange Geschäftsgeheimnisse und andere geistige Eigentumsinteressen angemessen geschützt sind.

4. Das Unternehmen übt keine Vergeltung an aktuellen und ehemaligen Mitarbeitern, die risikobezogene vertrauliche Informationen öffentlich teilen, nachdem andere Prozesse gescheitert sind.

-

Articoli correlati

Gesellschaft | TechnologieBeängstigender Fortschritt

Gesellschaft | PhilosophieKI - mehr als nur Technologie?

Wirtschaft | KIRisiko KI

Acconsenti per leggere i commenti o per commentare tu stesso. Puoi revocare il tuo consenso in qualsiasi momento.